ML estimatoren resulterer i verdien for parameteren som mest sannsynlig vil forekomme i datasettet.

Gitt forutsetningene, er ML estimatoren verdien av parameteren som har den beste sjansen for å produsere datasettet.

Jeg kan ikke intuitivt forstå en partisk ML-estimator i den forstand at "Hvordan kan den mest sannsynlige verdien for parameteren forutsi den virkelige verdien til parameteren med en skjevhet mot en feil verdi? "

Skjevhet handler om forventninger om samplingsfordelinger. "Mest sannsynlig å produsere dataene" handler ikke om forventningene til distribusjon av prøvetaking. Hvorfor forventes det at de går sammen?

Hva er grunnlaget det er overraskende at de ikke nødvendigvis samsvarer med?

Jeg vil foreslå at du vurderer noen enkle tilfeller av MLE og tenk på hvordan forskjellen oppstår i de spesielle tilfellene.

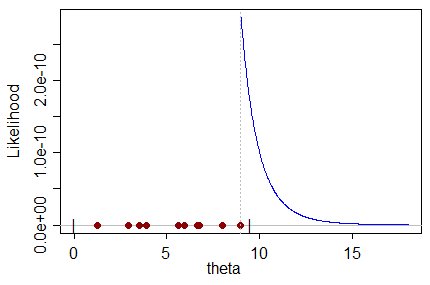

Som et eksempel kan du vurdere observasjoner på uniform på $ (0, \ theta) $ . Den største observasjonen er (nødvendigvis) ikke større enn parameteren, så parameteren kan bare ta verdier som er minst like store som den største observasjonen.

Når du vurderer sannsynligheten for $ \ theta $ , det er (åpenbart) større jo nærmere $ \ theta $ er den største observasjonen. Så det er maksimert at den største observasjonen; det er tydeligvis estimatet for $ \ theta $ som maksimerer sjansen for å få prøven du fikk:

Men på den annen side må det være partisk, siden den største observasjonen åpenbart (med sannsynlighet 1) er mindre enn den sanne verdien av $ \ theta $ ; ethvert annet estimat av $ \ theta $ som ikke allerede er utelukket av selve prøven, må være større enn det, og må (ganske tydelig i dette tilfellet) være mindre sannsynlig å produsere prøven.

Forventningen om den største observasjonen fra en $ U (0, \ theta) $ er $ \ frac {n } {n + 1} \ theta $ , så den vanlige måten å uklare er å ta som estimator for $ \ theta $ : $ \ hat \ theta = \ frac {n + 1} {n} X _ {(n)} $ , der $ X _ {( n)} $ er den største observasjonen.

Dette ligger til høyre for MLE, og har så lavere sannsynlighet.